Après vous avoir présenté en 2018 l’infrastructure 2015 de la Maison Bleue avec la fibre Orange, voici l’architecture 2020… entièrement 10 Gigabit Ethernet (GbE) avec la fibre Free !

Plusieurs points m’ont poussé à changer mon infrastructure en 2019 :

- Pour rappel, j’utilisais la fibre Orange avec le WAN en DHCP et plusieurs VLAN (pas de mode bridge chez Orange) pour récupérer les différents flux (Internet, TV, téléphone) sur un routeur pfSense. Mais j’ai fini par rencontrer des dysfonctionnements en perdant alternativement un service, soit la TV, soit le téléphone, certainement en raison de modifications techniques de la part d’Orange. Un passage sur OPNsense, pourtant plus optimisé que pfSense concernant l’intégration de la fibre Orange, ne changea rien à mes difficultés,

- Par ailleurs, mes 2 baies 10″ avaient atteint leurs limites : peu d’espace pour intervenir sur le matériel en cas de panne et trop peu de dissipation de chaleur en été, provoquant en 2019 des surchauffes et des pannes,

- Et pour finir, l’envie de passer à des vitesses rêvées mais inaccessibles pour les particuliers jusqu’à présent. La lecture de ce topic sur le forum lafibre.info m’a beaucoup inspiré…

Ayant libéré de la place dans ma cave, j’ai décidé de passer à une baie 19″ pour avoir plus d’espace lors des interventions physiques et une meilleure aération, mais aussi de changer d’opérateur et passer chez Free avec la Freebox Delta S en mode bridge (offre sans box TV car j’ai ma propre box TV). Elle offre un débit de 10 Gb/s en download sur le WAN (8 Gb/s dans la pratique) et 700 Mb/s en upload. Une interface SFP+ pour le LAN permet d’atteindre le 10 Gigabit Ethernet et le mode bridge facilite la mise en œuvre d’un routeur privé. Par ailleurs, j’ai demandé via l’espace abonné Free une adresse IP fixe V4 full-stack ce qui facilite l’accès aux différents serveurs Web que j’héberge.

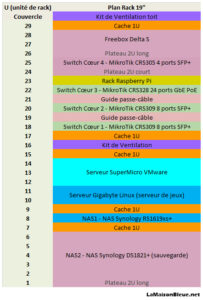

Après une phase de réflexion sur « papier », j’ai déterminé les équipements dont j’avais besoin ainsi que la hauteur utile de la baie 19″ et rédigé un tableau Excel en plaçant tous les éléments nécessaires à mon projet :

MAJ juillet 2024 : après une coupure électrique de plusieurs heures dans mon quartier, je me suis finalement décidé à acquérir un onduleur pour protéger les 2 NAS avec le modèle rackable Eaton 5P850IR.

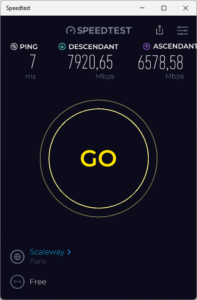

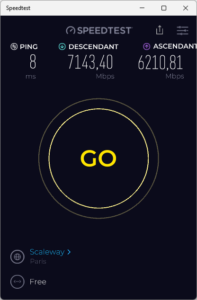

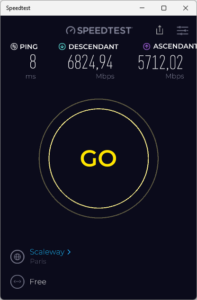

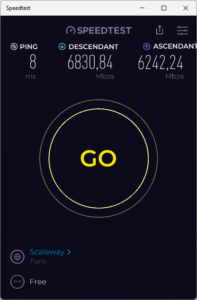

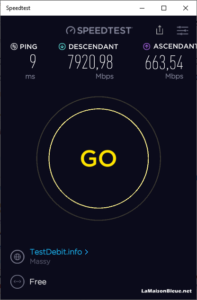

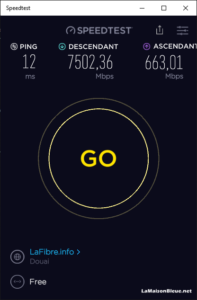

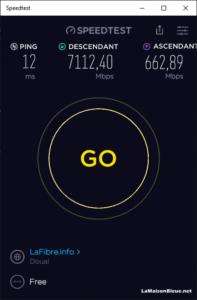

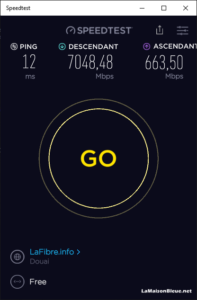

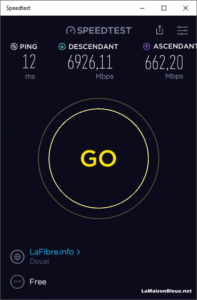

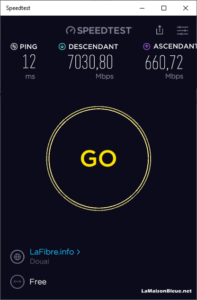

Mais surtout, je suis maintenant passé à la Freebox Ultra Essentiel (sans box TV) avec un débit symétrique de 8 Gb/s 🎉🎉🎉 Voici les résultats de tests réalisés avec l’app Speedtest sous Windows 11 à différentes heures de la journée, 8h, 12h, 16h et 20h et minuit :

|

|

|

|

Câblage

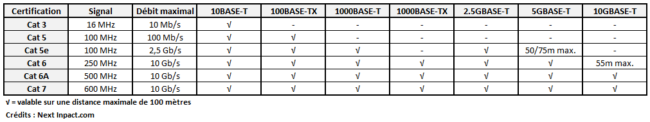

En 2012, j’avais installé un câblage Cat 6 dans la maison. Pour du 10 GbE, il est préconisé d’utiliser la Cat 6a ou Cat 7 mais la Cat 6 accepte le 10 GbE sur une distance max de 55 mètres :

Sur ce point, je fus fixé lors des tests effectués sur le PC le plus éloigné du répartiteur.

J’ai par contre remplacé tous les câbles RJ45 dans les étages par des câbles blindés SFTP Cat 7 achetés chez FS.com. C’est également sur ce site que j’ai acheté les câbles DAC SFP+ nécessaires pour interconnecter les switches entre eux et les serveurs aux switches.

C’est aussi chez FS.com que j’ai acquis 2 trunks de 6 câbles Cat 6a de 7 mètres de long pour connecter, sur le premier trunk, les 6 prises RJ45 du répartiteur aux différents switches situés dans la baie 19″.

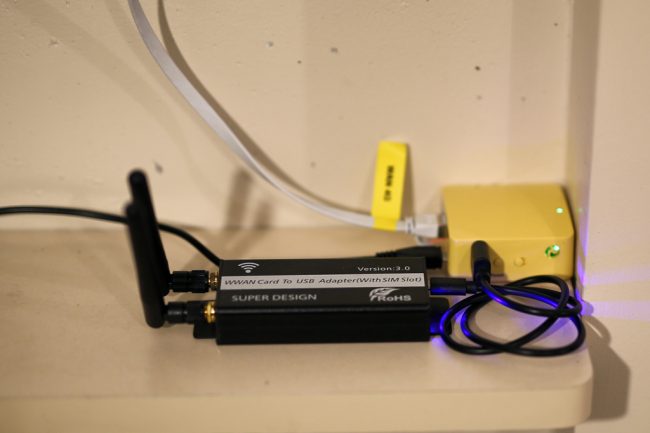

Pour le second trunk, j’ai connecté aux switches les équipements présents autour de la baie, les caméras IP, la base DECT et le routeur 4G :

|

|

J’ai également utilisé une gaine électrique pour connecter en toute sécurité la fibre optique du PTO situé près du répartiteur et le câble téléphonique RJ11 de la base DECT à la Freebox Delta S située dans la baie 19″.

Les 2 trunks et la gaine voyagent eux-mêmes dans plusieurs tubes d’évacuation de 60 mm de diamètre du répartiteur en direction de la baie 19″ :

|

|

|

|

J’ai également fait installer par un professionnel deux prises électriques à proximité de la baie 19″ jusqu’au tableau électrique général sur deux disjoncteurs dédiés. J’ai veillé à bien différencier le chemin du courant fort (électrique) du chemin du courant faible (réseau).

Réseau

Concernant les switches, après avoir utilisé un switch MikroTik RB260GS dans ma précédente infra et apprécié la facilité de paramétrage, mon choix s’est donc porté sur la gamme MikroTik, notamment pour les switches SFP+ supportant le 10 GbE :

- Deux switches MikroTik CRS309 8 ports SFP+ pour le cœur de réseau

- Complétés par un troisième switch GbE PoE, un MikroTik CRS328 24 ports GbE PoE

- Et un dernier switch pour la DMZ, un MikroTik CRS305 4 ports SFP+

- Dans les étages, pour les 3 PC fixes, un switch MikroTik CRS305 4 ports SFP+

Dans les autres pièces où j’ai besoin du PoE pour les caméras IP et les points d’accès Wifi, je n’ai pas trouvé de petits switches dans la gamme MikroTik supportant la norme 802.3af. J’ai décidé alors d’utiliser les switches de la gamme Netgear, le GS105PE et le GS108PE.

J’en ai profité pour changer les points d’accès Wifi Cisco WAP371 par des UniFi UAP FlexHD d’Ubiquiti de bien meilleure qualité à l’usage.

J’utilise les modules ou câbles SFP+ suivants sur les différents switches SFP+ :

- Les modules SFP+ MikroTik S+RJ10 avec une interface RJ45 pour les PC équipés d’une carte réseau 10 GbE. Attention de bien choisir un module MikroTik SFP+ S+RJ10 Rev. 2 et non Rev. 1 car seule la révision 2 supporte les Jumbo Frames

- Le module SFP MikroTik S-RJ01 avec une interface RJ45 pour les équipements dotés d’une connexion 1 GbE (imprimante, TV…)

- Les câbles DAC SFP+ 10G pour interconnecter les switches et les serveurs dans la baie 19″

Stockage

J’ai aussi réfléchi au stockage car il reste un goulot d’étranglement important pour un réseau 10 Gb/s. Pour mémoire, les débits moyens en lecture sont les suivants sur les 3 technos majeures :

- HDD SATA 2.5″ ou 3.5″ : 120 Mo/s soit environ 1 Gb/s

- SSD SATA 2.5″ : 500 Mo/s soit 4 Gb/s

- SSD NVMe M.2 : 3000 Mo/s soit 24 Gb/s

La solution idéale aurait été d’équiper toutes les machines uniquement en SSD NVMe M.2, mais n’existant pas ou alors coûtant un bras pour les très grandes capacités, j’ai donc choisi les disques suivants en fonction du type de machine :

- Les 3 PC fixes : 1 SSD NVMe M.2 pour le système Windows 10 et 1 SSD SATA pour les données

- Le serveur WMware : 1 SSD NVMe M.2 pour l’hyperviseur VMware et 4 SSD SATA 2.5″ en RAID 10 pour les données

- Le serveur de jeux : 1 SSD NVMe M.2 pour le système Linux Debian et 1 SSD SATA 2.5″ pour les données

- Le NAS1 : 2 SSD NVMe M.2 pour le cache et 4 HDD SATA 3.5″en RAID 10 pour le système et les données

- Le NAS2 : 2 SSD NVMe M.2 pour le cache, 5 HDD SATA 3.5″en RAID 5 pour le système et les données du 1er volume et 1 HDD SATA 3.5″en RAID 0 pour le 2nd volume

J’ai dû acquérir une carte RAID Broadcom LSI pour le serveur VMware car malheureusement il ne reconnaissait pas le RAID proposé par la carte-mère Supermicro. J’ai alors hésité entre m’équiper de SSD NVMe M.2 et SSD SATA 2.5″. Mais là aussi VMware ESXi impose ses limites et ne reconnait pas vROC d’Intel pour le moment qui permettrait l’intégration d’un RAID NVMe M.2 à moindre coût. Il fallait s’équiper d’une carte RAID Broadcom LSI 9400-16i et de SSD NVMe U.2 prévus pour équiper les Datacenter… ce qui a fini par me conforter mon choix de rester en SSD SATA 2.5″ pour le moment.

Baie

Restait encore à trouver une baie 19″ et deux serveurs 19″, l’un pour héberger WMware et tous les serveurs virtuels et l’autre pour un serveur de jeux. Mon choix s’est finalement porté sur Cablematic, un fabricant Catalan :

- Rack 19 « 29U de la gamme RackMatic MobiRack 600x800x1400mm + tous les accessoires comme les plateaux, les kits de ventilation (deux pour être sûr de bien ventiler la baie en été), rails latéraux pour rigidifier la baie, rails latéraux pour supporter le poids des serveurs, panneaux d’obturation 1U, guides passe-câbles 1U avec pinceau, guide-câbles avec anneaux pour gérer les câbles à l’arrière de la baie, bagues de gestion des câbles, multiprises 1U, les écrous cage…

- Boîtier châssis rack 19″ 3U avec une baie 4 disques durs IPC microATX et ATX d’une profondeur de 400mm pour le serveur WMware

- Boîtier châssis rack 19″ 2U IPC ATX et EATX d’une profondeur de 380mm pour le serveur de jeux

Le dernier serveur rack qui équipe la baie est le NAS1, un Synology RackStation RS1619xs+, qui lui est livré quasiment tout équipé sauf disques, mémoire et carte d’extension.

Le NAS2 dédié à la sauvegarde, un Synology DiskStation DS1821+, est non rackable et livré également quasiment tout équipé sauf disques et carte d’extension.

La baie avec tous les équipements :

La baie lors du montage que j’ai pu effectuer seul sauf pour 2 ou 3 manipulations :

Les parties « réseau » et « serveur » de la baie :

|

|

Serveurs

Pour le serveur VMware, je souhaitais un processeur Xeon assez puissant pour installer une dizaine de serveurs virtuels, 4 disques en RAID 10 et 64 Go de mémoire. J’ai donc choisi les composants suivants :

Pour le serveur VMware, je souhaitais un processeur Xeon assez puissant pour installer une dizaine de serveurs virtuels, 4 disques en RAID 10 et 64 Go de mémoire. J’ai donc choisi les composants suivants :

- Processeur Intel Xeon E5–2630 v4 2.20 GHz 10 cœurs

- Carte-mère Supermicro X10SRM-F

- Ventirad Supermicro SNK-P0048AP4

- 4 x Mémoire HyperX HX424C15FB3/16 (16 Go) DDR4 2400MHz

- Alimentation ATX Corsair VS650 650W

- Carte Réseau Intel X710-DA4 4 Ports SFP+ avec 1 port SFP+ pour le WAN, 2 pour le LAN (LAG LACP) et 1 pour la DMZ

- Carte Réseau Ipolex Intel 82576 Chip 2 ports GbE

- Carte RAID Broadcom LSI MegaRAID SAS 9271-4i

- 1 x SSD NVMe M.2 Samsung 970 PRO 512 Go sur lequel a été installé l’hyperviseur VMware ESXi

- 4 x SSD SATA 2.5″ Samsung 860 EVO 2 To pour les VM et les données (RAID 10)

- 3 x Ventilateur Noctua NF-A8 PWM

Le serveur de jeux est composé entre autre d’une carte-mère, d’un processeur et de la mémoire récupérés sur un PC mis à jour :

Le serveur de jeux est composé entre autre d’une carte-mère, d’un processeur et de la mémoire récupérés sur un PC mis à jour :

- Processeur Intel Core i7-6700K 4 GHz 4 cœurs

- Carte-mère Gigabyte GA-Z170X-Gaming 3-EU

- Ventirad Noctua NH-L9i faible hauteur

- Mémoire Corsair Vengeance LPX 2x8Go DDR4 2400MHz

- Alimentation Flex Silverstone SST-FX350-G 350W

- Carte réseau Intel X710-DA2 2 Ports SFP+ avec 1 port SFP+ utilisé sur les 2

- 1 x SSD NVMe M.2 Samsung 970 PRO 512 Go sur lequel a été installé le système Linux Debian

- 1 x SSD SATA 2.5″ Samsung 860 EVO 1 To pour les données

Le NAS Synology RS1619xs+ (NAS1) a été complété par les éléments suivants :

Le NAS Synology RS1619xs+ (NAS1) a été complété par les éléments suivants :

- 4 x Mémoire Crucial CT16G4WFD8266 16GB DDR4 2666MHz que j’ai acheté directement sur le site Crucial qui propose de la mémoire compatible avec les NAS Synology

- Carte Réseau Intel X710-DA2 2 Ports SFP+ avec les 2 ports SFP+ sur le LAN (LAG LACP)

- 2 x SSD NVMe M.2 Samsung 970 PRO 256 Go utilisés pour le cache

- 4 x HDD SATA 3.5″ Seagate IronWolf 8 To pour le 1er volume du NAS (RAID 10)

MAJ décembre 2021 : pour les sauvegardes, j’ai remplacé les Docks StarTech par un NAS Synology DS1821+ (NAS2) qui a été complété par les éléments suivants :

MAJ décembre 2021 : pour les sauvegardes, j’ai remplacé les Docks StarTech par un NAS Synology DS1821+ (NAS2) qui a été complété par les éléments suivants :

- 2 x Mémoire Kingston KSM26SES8/16HA 16Go DDR4 2600MHz ECC. A la date d’achat du NAS, le site Crucial ne proposait malheureusement pas de mémoire compatible avec ce modèle. A noter que le NAS affiche un message d’alerte à chaque redémarrage sur l’utilisation de « modules mémoire non recommandés par Synology ». Toutefois, je n’ai rencontré à ce jour aucun dysfonctionnement ou plantage du NAS avec l’utilisation de mémoires Kingston

- Carte Réseau Synology Network Card SFP+ E10G21-F2 avec les 2 ports SFP+ sur le LAN (LAG LACP)

- 2 x SSD NVMe M.2 Crucial P2 250 Go utilisés pour le cache

- 5 x HDD SATA 3.5″ Seagate IronWolf 8 To, dont 2 récupérés de l’ancien dock de sauvegarde du NAS Synology RS1619xs+, pour le 1er volume du NAS (RAID 5)

- 1 x HDD SATA 3.5″ Western Digital Red NAS 10 To , récupéré de l’ancien dock de sauvegarde du serveur VMware, pour le 2nd volume du NAS (RAID 0)

MAJ février 2022 : j’avais deux Raspberry Pi 3 B+ en stock et, après avoir vu ce projet de cluster Raspberry Pi pour miner des Dogecoin, j’ai décidé de réaliser ce projet en lab mais sur une échelle plus petite avec trois Raspberry Pi. J’ai finalement acheté deux Raspberry Pi 4 B car l’un des deux Pi 3 B+ dysfonctionnait :

MAJ février 2022 : j’avais deux Raspberry Pi 3 B+ en stock et, après avoir vu ce projet de cluster Raspberry Pi pour miner des Dogecoin, j’ai décidé de réaliser ce projet en lab mais sur une échelle plus petite avec trois Raspberry Pi. J’ai finalement acheté deux Raspberry Pi 4 B car l’un des deux Pi 3 B+ dysfonctionnait :

- Rack 1U 19″ pour cinq Raspberry Pi 3 B+ ou 4 B

- 2 x Raspberry Pi 4 B 2 Go

- 3 x PoE+ HAT pour l’alimentation des Raspberry Pi via PoE

- 3 x Carte microSD SanDisk Extreme 32 Go

- 10 x Câble réseau Cat.7 de 25 cm de plusieurs couleurs

PC

Enfin les PC ont été mis à jour pour supporter le 10 GbE :

Enfin les PC ont été mis à jour pour supporter le 10 GbE :

- Carte-mère MSI MPG Z390M Gaming Edge AC

- Processeur Intel Core i7-8700 3.2GHz 6 cœurs

- Mémoire Corsair Vengeance LPX 2x8Go DDR4 2666MHz

- Alimentation ATX Be Quiet Straight Power 11 650W

- Carte Réseau Asus XG-C100C 10 GbE que j’ai remplacé par des cartes 10Gtek Intel X550-T1 10GbE pensant à tort que les dysfonctionnements liés à l’utilisation des Jumbo Frames (MTU de 9000 octets) étaient dus à la carte réseau Asus. Mais finalement, ils étaient causés par les modules MikroTik SFP+ S+RJ10 qui étaient tous en Rev. 1 alors que le Jumbo Frame était accepté seulement depuis la Rev. 2… J’ai pu heureusement les échanger par des modules MikroTik SFP+ S+RJ10 Rev. 2

- 1 x SSD NVMe M.2 Samsung 970 PRO 512 Go sur lequel a été installé le système Windows 10

- 1 x SSD SATA 2.5″ Samsung 860 EVO 1 To pour les données

- Carte Graphique MSI GeForce GTX 970 Gaming 4G – 4Go GDDR5 – PCI-E 3.0

Archi 2020

Voici un schéma de principe de l’architecture 2020 :

Infra_La_Maison_Bleue_Net_2020_001Télécharger

Et quelques résultats de tests sur le WAN réalisés avec l’app Speedtest sous Windows 10 à différentes heures de la journée, 4h, 8h, 12h, 16h, 20h et minuit :

|

|

|

|

|

|

On constate qu’à 4h du matin, quand peu de gens sont connectés, le résultat n’est pas loin du débit max qu’offre la fibre Free 10G-EPON mutualisée, soit 8 Gb/s. Quant à l’upload, il reste constant à 660 Mb/s quelle que soit l’heure de la journée, très proche du max à 700 Mb/s.

A noter que ces résultats ont été obtenus en utilisant un firewall Untangle, alors qu’avec le firewall pfSense, je ne dépassais pas les 2,4 Gb/s. J’ai changé très récemment de firewall après avoir lu ce topic sur le forum SMPFR.info, cherchant depuis des mois pourquoi je n’atteignais pas des débits supérieurs.

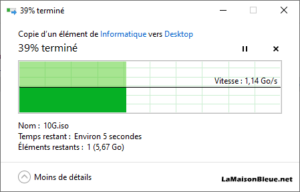

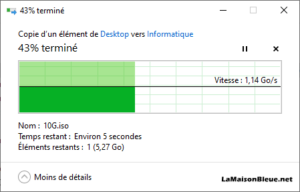

Sur le LAN, une lecture et écriture sur le NAS1 donnent les mêmes résultats :

|

|

Il est possible d’atteindre des pointes à 1,22 Go/s en lecture, c’est-à-dire tout proche du débit max de 10 Gb/s. Ces performances sont possibles grâce à l’utilisation du cache du NAS1 composé de deux SSD NVMe M.2 qui remplissent très bien leur rôle sur un réseau 10 GbE alors que les disques principaux ne sont que des HDD SATA. Elles sont possibles aussi grâce aux Jumbo Frames mises en œuvre sur tous les systèmes, VMware, Linux, Windows, serveurs et PC et le firewall Untangle.

Les transferts vers les serveurs virtuels VMware dans le même VLAN ou non (LAN ou DMZ) donnent une vitesse moyenne de 4 Gb/s conforme aux limites des SSD SATA installés sur le serveur VMware.

Conclusion

Le prochain article détaille l’infrastructure réseau avec le paramètrage des switches, des VLAN et des AP Wifi.

Bonjour Laurent,

Je suis en train de changer mon réseau et j’ai une question au sujet de la Delta:

Tu l’utilises en mode bridge ?

En fait je voudrais l’utiliser en mode bridge mais je ne sais pas comment faire pour relier le SFP+ à l’entrée de mon routeur qui est du multigb mais en RJ45:

J’ai bien pensé à un switch mais il ne fonctionnera pas sans routage en amont, si ?

Et la Delta n’est pas assez puissante pour utiliser un convertisseur SFP+-RJ45

Un conseil ?

Merci

Bruno

Bonjour Bruno,

Oui la Delta est bien en mode bridge. Il y a un port SFP+ sur la Delta sur lequel il faut brancher un câble DAC SFP+ et sur l’autre extrémité au minimum un switch SFP+ comme le Mikrotik CRS305 ou CRS309 et un équipement routeur/firewall.

Ou comme chez moi un serveur équipé d’une carte réseau SFP+ sur lequel tourne un firewall/routeur capable de traiter du 10GbE comme le firewall Untangle (voir le schéma réseau dans cet article).

Bonjour Laurent.

Je suis impressionné par votre installation.

Dans une bien moindre mesure, je dispose actuellement d’une simple connexion ADSL2 avec Free (9 Mbits/s environ)

Je sais que la fibre arrive bientôt dans ma campagne, mais je m’attendais à avoir maximum 1Gbits/s

Je vous entend parler de 8 à 10Gbits/s ??? est ce pour tous les abonnées Free même dans les rases campagnes comme moi ?

Cela signifie que tous les abonnés Free au final sous utilisent leurs connexion (peu de gens sont équipés en 10Gbits … personne d’ailleurs…

Pour ma part j’ai un PFSENSE installé sur une APU 2C2 avec pour l’instant la Freebox ADSL en mode Bridge.

Je me pose donc la question du remplacement de mon infra quand la fibre sera disponible.

Que se soit au niveau de PFSENSE, que des Switch (J’ai des unifi US-8-60W pour l’instant et donc Giga…)

Cela signifie aussi que les Freebox sont livrées avec un SFP+ 10Gbits/s pour l’interco avec un routeur ?? J’imagine que c’est la Delta

Bonjour,

Il faudra bien vérifier auprès de Free que vous pouvez souscrire un abo pour une Freebox Delta ou Delta S (mon choix) et bénéficier du 10G.

Car en effet, dans les rases campagnes, j’ai un petit doute… peut-être poser la question sur un forum dédié Free FTTH pour avoir un retour d’expérience…

Vous trouverez plus d’infos sur l’interco entre la Freebox et le serveur VMware dans l’article suivant.

La Freebox Delta possède bien un port SFP+ (10Gb) et le serveur VMware plusieurs ports SFP+ via une carte Intel X710-DA4 4 Ports SFP+. Les 2 équipements sont interconnectés via un câble DAC SFP+.

Et c’est pas fini ! Il faut au milieu de tout ça des switchs compatibles SFP+. Plus d’infos dans l’article suivant…

Bonjour très belle installation.

Est-ce qu’à l’heure d’aujourd’hui, vous avez apporté des modifications sur votre configuration ?

Cordialement.

Bonjour,

Très peu, j’ai simplement changé un switch suite à la défaillance d’une prise RJ45 dans mon salon (voir article sur les switches et VLAN).

Je compte aussi acquérir en décembre un autre NAS Synology uniquement dédié aux sauvegardes car elles encombrent le NAS actuel.

J’essaie d’avancer sur l’article au sujet du firewall mais… il faut que je retrouve de la motivation et du temps 🙂

Super article intéressant et bien expliqué !

Comptez vous installer de la QoS dans votre infra ?

Bonjour,

Disons qu’à 10 GbE, je n’en sens pas le besoin pour le moment 🙂

Bonjour

Votre installation est tres aboutie et performante et cela merite mes félicitations..

Ma maison est en construction et je cable tout mon reseau local en GG45 Nexans 2000Mhz+cable Cat 8.2 2000 MHz qui peut faire passer du 40Gb -Base T maxi .Mon installation aura 24 prises murales toutes reliées a un bandeau de brassage GG45 Nexans place dans une baie de brassage 19″

je suis a l’ecoute de vos conseils pour organiser la configuration de mon installation qui gerera de la video surveillance dans chaque piece en PoE++ soit 7 camera iP 4 k + 1 ext . + alarme anti intrusion maison réalisée avec un automate Siemens S7-1200 avec du protocole KNX.

Free est actuellement le seul opérateur a fournir en FTTH du 8 Gb cela reduit forcément le choix des possibilités offertes..

Actuellement,je dois choisir l’equipement de la baie :

le switch principai 24 ports 10 GbE et le nas 10 GbE rackable dans la baie info+ périphériques annexes

Cordialement

Bonjour,

Top installation pour votre maison !

Vous avez bien raison de câbler en Cat 8 car tout évolue tellement vite !

Je ne connais pas l’automate Siemens mais ça a l’air super.

De mon côté, j’ai quelques prises domotiques, un thermostat Netatmo et une clim Daikin, le tout en Wifi piloté par Jeedom. Les caméras sont IP PoE connectés à Jeedom mais aussi à Surveillance Station du NAS qui se charge des enregistrements en cas de mouvement. Ma « petite Domotique » fera l’objet d’un article quand je vais décliner les serveurs virtuels installés sur le serveur VMware.

Pour l’opérateur, difficile en effet de faire mieux que Free aujourd’hui avec le 10 Gb et le mode bridge.

Concernant les switches, je n’ai pas vu de switch 24 ports SFP+ ou 10 GbE chez MikroTik mais à voir la gamme Ubiquiti ou Netgear.

Peut-être installer 2 ou 3 MikroTik CRS309 connectés entre eux par 2 ports SFP+ en un trunk LAG pour obtenir un lien de 20 GbE ?